AMD Zen 7 Verano y MI500: Mega-Pods de 256 GPUs. AMD perfila su siguiente salto en IA para data center con EPYC “Verano” (Zen 7) y Instinct MI500, buscando escalar a pods con 64 CPUs y 256 GPUs en 2027. La idea es simple: más densidad, menos cuellos de botella y mejor coste por entrenamiento.

¿Qué propone AMD con Verano + MI500?

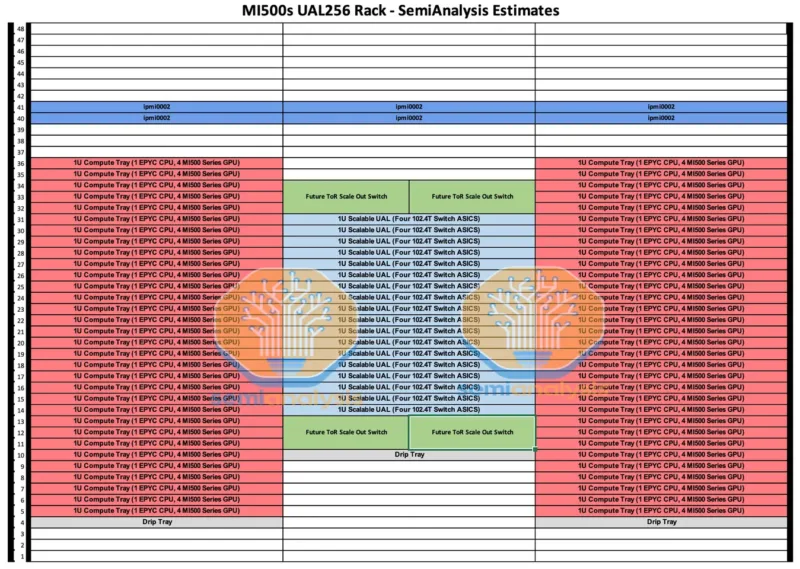

Cada nodo combinaría una CPU Verano con cuatro GPUs MI500. A plena escala, el pod subiría hasta 64 CPUs y 256 GPUs, una configuración pensada para entrenamiento de LLM y cargas HPC. Objetivo: ancho de banda alto y latencia baja para alimentar a las GPUs sin frenar el rendimiento.

Red y conectividad de nueva generación

La interconexión llega con Vulcano (NIC/DPU de próxima generación) y 800G, junto a PCIe Gen6 y UALink. Este combo apunta a alimentar la granja de GPUs con más datos y menos esperas. En la práctica, supone más eficiencia y mejor escalado cuando el modelo crece.

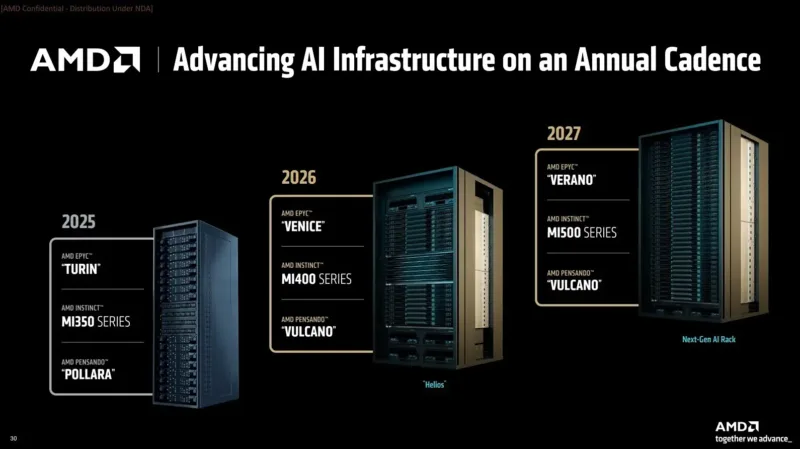

Hoja de ruta: de Helios 2026 a Verano 2027

En 2026, AMD pondrá en el mercado Helios con Instinct MI400 y EPYC “Venice” (Zen 6). El paso siguiente sería MI500 + EPYC “Verano” (Zen 7) en 2027, manteniendo plataforma SP7 y una cadencia anual. Para los centros que ya estén en AMD, eso significa actualizaciones menos traumáticas y reutilización de infraestructura.

Por qué importa para la IA en 2027

- Más GPU por pod → más rendimiento por rack.

- Tejidos de red más rápidos → menos tiempo de entrenamiento y mejor uso de cada GPU.

- Ecosistema abierto (ROCm, UALink, UEC) → flexibilidad para integradores y nubes.

Lo que todavía no está cerrado

- Cómputo y memoria exactos de MI500 (FP8/FP4, HBM, anchos).

- Límites de núcleos e IPC finales de EPYC Verano.

- Topologías: hay reportes que hablan de pods de 256 GPUs, y otros de 144 GPUs por sistema; podrían coexistir variantes según consumo, espacio y coste.

Ficha rápida (provisional)

- CPU: EPYC “Verano” (Zen 7), SP7, PCIe Gen6, UALink.

- GPU: Instinct MI500 (posterior a MI400/Helios).

- Escala por pod: 64 CPUs + 256 GPUs (diseño UAL256).

- Red: Vulcano con hasta 800G y mayor ancho de banda por GPU.

- Ventana temporal: 2027 (después de Helios/MI400 en 2026).

- Enfoque: IA generativa, entrenamiento de LLM y HPC a gran escala.